Von Livepeer, Übersetzung des Artikels ¨AI in Media: How Generative AI is Transforming Video Production¨ von Andy Schreiber

Die Einführung der leistungsstarken generativen Video-KI markiert ein Vorher und Nachher für die Kreativbranche.

Das Video-KI-Fieber begann mit Runway im Jahr 2023, als das Unternehmen Gen-2, sein bahnbrechendes Modell zur Videogenerierung, auf den Markt brachte. Das war ein großer Fortschritt gegenüber den verzerrten und klobigen Bildern, an die die Öffentlichkeit gewöhnt war. Der eigentliche Wendepunkt war die Einführung von Sora von OpenAI. Sora erzeugte nicht nur Videos in atemberaubender Qualität, sondern war auch in der Lage, Clips zu erstellen, die als reale Aufnahmen durchgehen konnten. Die Dinge sollten nie wieder so sein wie zuvor und die Videoproduktion wurde für immer verändert.

Aber all diese Innovationen sind privat, Closed-Source und oft nur auf Abonnementbasis erhältlich. Deshalb entwickeln sich kostenlose und quelloffene Optionen wie Stable Diffusion zu einer ernsthaften Konkurrenz für die Modelle der Mainstream-Generation. In Kombination mit dem dezentralen und erschwinglichen Zugang zu KI-Computing ist der Weg frei für eine offene KI-Video-Infrastruktur für alle.

In diesem Artikel wird untersucht, wie die führenden Modelle zur Erzeugung von KI-Videos die Videoproduktion verändert haben, welche Projekte sie entwickelt haben und wie Open-Source-Modelle diesen heiß umkämpften Markt aufmischen.

Sora setzt einen neuen Standard

Sora ist ein Videogenerierungsmodell von OpenAI, dem Unternehmen hinter dem einflussreichen chatGPT. Sora kann derzeit fotorealistische Videos von bis zu einer Minute Länge erstellen, die auf Benutzeranweisungen im Bild-zu-Video- oder Text-zu-Video-Format basieren.

Die Veröffentlichung von Sora war ein Durchbruch im Vergleich zu allem anderen auf dem Markt. Anstelle der früheren traumhaften Inkarnationen von Text-zu-Video-Generatoren mit Bildern, die wie ein surrealer, lebensechter Wandteppich triefen und fließen, konnte Sora Videos produzieren, die zwar nicht sofort überzeugend waren, dass es sich um echte Bilder handeln könnte, die aber den durchschnittlichen Internetnutzer zweimal hinschauen ließen.

Die Einführungsvideos von Sora schlugen hohe Wellen, da sie eine Vielzahl von Möglichkeiten des Modells zeigten, von einer Herde Wollmammuts, die sich über ein schneebedecktes Bergplateau bewegt, bis hin zu einem glücklichen jungen Paar, das durch eine belebte Winterstadtlandschaft spaziert.

Trotz der Millionen von begeisterten Internet-Kreativen bleibt Sora für fast alle unzugänglich. Bislang ist das Modell nur für eine ausgewählte Gruppe von Testern, Filmemachern, bildenden Künstlern und Designern verfügbar. Doch das wird sich bald ändern. Wie OpenAI-CTO Mira Murati berichtet, wird das Modell zur Videogenerierung im Jahr 2024 verfügbar sein.

Doch Sora ist nicht das einzige Modell zur Videogenerierung auf dem Markt. Das Modell von OpenAI hat eine wachsende Liste von Konkurrenten, vor allem Runway und Pika Labs.

Runway

Als das Unternehmen sein Gen 2-System auf den Markt brachte, war das ein großer Sprung nach vorn, was die öffentliche Wahrnehmung dessen, was KI schaffen kann, angeht.

Gen 2 war sowohl ein Bild-zu-Video- als auch ein Text-zu-Video-System und erstellte etwas, das in etwa dem entsprach, was die Nutzer wollten, mit einer Länge von bis zu 3 Sekunden. Jetzt können die Ersteller standardmäßig 4-Sekunden-Videos erstellen, mit der Option, die Aufnahme auf insgesamt 16 Sekunden zu verlängern, sowohl für Bild- als auch für Text-zu-Video-Aufforderungen.

Im Februar 2024 enthüllte Runway einige Details zu Gen 3 und hob die detaillierte zeitliche Steuerung für dramatische Übergänge und fotorealistische Menschen mit einer breiten Palette von Aktionen, Gesten und Emotionen hervor.

Runway lehnt sich wirklich an das ernsthafte kulturelle und filmische Element der generativen KI an. Es wurde sogar ein eigenes KI-Filmfestival ins Leben gerufen, das jedes Jahr stattfindet. Filmemacher aus aller Welt können über einen Runway-Link bis zu 10 Minuten lange Filme einreichen, die KI-gestützte Tools enthalten. Der Hauptpreis ist 15.000 $ und 1 Million Runway-Credits.

Letztes Jahr gewann der Filmemacher Daniel Antebi den Hauptpreis mit seinem gespenstischen Film “Get Me Out”, in dem ein Mann gegen albtraumhafte übernatürliche Kräfte kämpft, die ihn in einem scheinbar gewöhnlichen Haus in einem US-Vorort gefangen halten. Der Film ist zwar kein Oscar-Gewinner, aber er beweist, dass KI effektiv in ernsthafte Filmgeschichten integriert werden kann.

Pika.

Pika ist in gewisser Weise ein Ableger des ursprünglichen generativen Videomodells von Runway.

Die Mitbegründerin von Pika, Demi Guo, war fest entschlossen, mit Runway einen Film zu drehen. Guo arbeitete monatelang an ihrem Film, war aber am Ende frustriert von dem, was eine Gruppe hochtechnisierter Leute mit Hilfe des Generators produzieren konnte.

Daher brach sie ihr Studium an der Stanford University ab und gründete Pika mit dem Ziel, einen benutzerfreundlicheren KI-Videogenerator für Amateurfilmer zu entwickeln. Seitdem hat Pika Millionen an Geldern und Nutzern gesammelt.

Pika bietet auch Text-, Bild- und Video-zu-Video-Konvertierungen und gibt den Nutzern die Möglichkeit, ihre Videos zu mischen, indem sie die Dimensionen ändern, Charaktere, Umgebungen und die Länge des Inhalts verändern.

Pika ist nicht für die Verwendung durch professionelle Filmemacher gedacht, aber es ist dennoch mehr als fähig, fesselnde Bilder zu erstellen, die eine Erzählung ausarbeiten können. Dieser mit Pika erstellte Sci-Fi-Trailer zeigt, dass man keine fotorealistische Qualität braucht, um etwas zu erstellen, das sofort eine starke Atmosphäre erzeugt und die Aufmerksamkeit des Zuschauers fesselt:

Pika-Gründer Guo erklärte gegenüber Bloomberg, dass Pika in der Lage sein wird, qualitativ hochwertige Videos von bis zu einer Minute Länge zu erstellen, und dass es in zwei Jahren zur Erstellung eines Spielfilms verwendet werden könnte. Das bedeutet aber nicht, dass es bis dahin keine signifikanten Auswirkungen auf die Filmproduktion und das Filmemachen geben wird — viele starke Clips und Werbespots sind viel kürzer als 10 Sekunden.

Unternehmenspartner suchen nach dem nächsten KI-Topmodell

KI-Videos sind nicht nur eine Art Experiment, um Langeweile zu vertreiben. Es handelt sich bereits um ein ernsthaftes Geschäft. Aus diesem Grund stehen bereits einige prominente Partner Schlange, um diese Modelle in ihr Geschäftsangebot aufzunehmen.

Im April 2024 erklärte der US-amerikanische Softwarehersteller Adobe, er befinde sich in einem frühen Stadium der Aktivierung von Tools wie OpenAIs Sora in seiner beliebten Anwendung Premiere Pro. Das klingt zwar vielversprechend, aber es ist zu bedenken, dass Adobes optimistische Aussagen über KI mehr damit zu tun haben könnten, den rückläufigen Aktienkurs anzukurbeln, als tatsächliche Produkte zu entwickeln.

Das kürzlich wiederbelebte Toys ‘R’ Us ist die erste große Marke, die Sora in ihrer Werbung einsetzt. Der Werbespot wurde auf dem Cannes Lions Festival, einem Treffen der internationalen Werbeelite, uraufgeführt und erhielt gemischte Kritiken. Einige lobten die Innovation von Native Foreign, der Agentur hinter dem Spot, während andere die mangelnde visuelle Konsistenz kritisierten, insbesondere das Aussehen der Hauptfigur. Unabhängig von den technischen oder künstlerischen Feinheiten der Anzeige ist sie ein Wendepunkt für den Einsatz von KI in der Werbung.

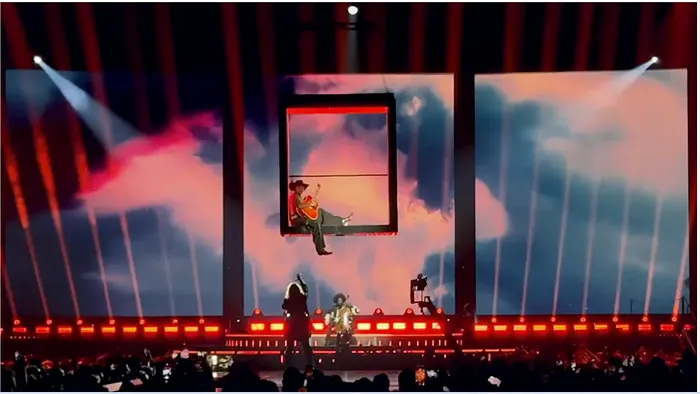

Nicht nur Sora bekommt viel Aufmerksamkeit. Madonnas Content Director, Sasha Kasiuha, sagte, dass sie Runway benutzt haben, um Statusvisuals für die Celebration-Tour der Queen of Pop zu erstellen.

Hollywood versteckt sich hinter seinen Händen

Viele Kommentatoren haben die künstliche Videoerzeugung als existenzielle Bedrohung für die Fernseh- und Filmindustrie bezeichnet. Das ist sicherlich übertrieben, aber es stimmt, dass die KI das Spielfeld für die Videoproduktion geebnet hat.

Szenen, für deren Erstellung ein Expertenteam erforderlich wäre, können jetzt mit wenigen kurzen Stichworten erstellt werden. Dadurch verringert sich nicht nur die potenzielle Gehaltsliste der Produktionsteams, sondern auch die Gesamtdauer der Dreharbeiten. KI kann auch bei Farbabstufungen, Szenenübergängen und anderen zeitaufwändigen Schnittarbeiten helfen.

Die KI-Videoproduktion ist von großer Bedeutung, weil sie der breiten Öffentlichkeit professionelle Qualitätswerkzeuge an die Hand gibt, ohne dass detaillierte Kenntnisse erforderlich sind. Dies ist ein Wendepunkt für unabhängige Kreative und sogar kleinere Studios. Professionelle Studios werden sich anpassen müssen, um wettbewerbsfähig zu bleiben, und KI in ihre Arbeitsabläufe integrieren müssen.

Auch wenn KI-Videos die Hollywood-Produktionsstudios vielleicht nicht über Nacht ersetzen können, bedeutet das nicht, dass die Auswirkungen nicht bereits zu spüren sind. Tyler Perry, ein US-amerikanischer Fernseh- und Filmmogul, sagte, dass er eine 800 Millionen Dollar teure Expansion seines Studios in Atlanta nach der Einführung von Sora gestoppt habe. Perry sagte, er sei zwar beeindruckt davon, wie die Technologie die Filmproduktion verbessern werde, aber er sehe den Verlust vieler Arbeitsplätze in der gesamten Branche voraus.

Open-Source-Modelle

Alle diese Modelle haben eines gemeinsam: Sie sind privat und quelloffen.

Der Gegensatz zwischen Open Source und Closed Source ist in der Welt der Technologie so alt wie die Branche selbst. Es gibt diejenigen, die der Meinung sind, dass Technologie frei verfügbar sein sollte, und diejenigen, die der Meinung sind, dass der Quellcode hinter innovativen Produkten hinter verschlossenen Türen bleiben sollte. In der Vergangenheit hat sich in der Regel die Closed-Source-Option durchgesetzt, weil gewinnorientierte Produkte ein besseres Gewinnpotenzial für Investoren bieten, was bedeutet, dass diese Produkte leichter zu finanzieren sind.

Aber KI-Video könnte dabei sein, diesen langjährigen Trend zu durchbrechen. Open-Source-KI-Videomodelle wie Stable Diffusion sind eine starke Konkurrenz.

Stable Diffusion ist für jeden verfügbar, der über die technischen Voraussetzungen für die Implementierung und den Betrieb verfügt. Es kann sowohl auf lokalen Geräten als auch in der Cloud eingesetzt werden. Stabile Videoübertragungen produzieren bereits vielversprechende Kurzvideos, und da sich die Modelle rasch weiterentwickeln, können wir in naher Zukunft noch hochwertigere Ergebnisse erwarten. Die Entwicklung und Aktualisierung kann aufgrund der Größe und des Aktivitätsniveaus einer großen Nutzergemeinschaft auch viel schneller erfolgen als bei Closed-Source-Modellen. Diese groß angelegte Zusammenarbeit ist einer der wichtigsten Gründe, warum Open-Source-Modelle innovative Leistungsupdates in einem Tempo liefern können, das sogar große, gut finanzierte Modelle übertreffen kann. Die Nutzung von Stable Diffusion ist im Allgemeinen kostenlos, abgesehen von den Kosten für den Betrieb der Modelle, die erheblich sein können.

Die Erstellung von KI-Videos ist in jedem Fall teuer. Das liegt daran, dass schon für die einfachsten Text-zu-Text-Aufgaben riesige Mengen an Berechnungen erforderlich sind, ganz zu schweigen von den komplexen Ergebnissen, die für KI-Videos benötigt werden.

Runway Gen-3 kostet 1 Dollar pro 10-Sekunden-Video.

Sora kann bis zu 6 $ kosten. Für ein kürzlich mit Sora erstelltes Musikvideo waren bis zu 700 Generationen erforderlich, die insgesamt mehr als 4000 $ kosteten.

Luma AI verlangt 400 Dollar für 30 Generationen von Dream Machine.

Die Kosten sind hoch, weil die Rechenanforderungen hoch sind. Außerdem sind die Server, die diese Leistung erbringen können, rar. Dies liegt daran, dass fast alle KI-fähigen Rechenkapazitäten von einer kleinen Handvoll Unternehmen wie NVIDIA, Microsoft und Amazon kontrolliert werden. Mit all der Macht und der Möglichkeit, die Preise für eine ständig steigende Nachfrage nach KI-Rechnern zu kontrollieren, gibt es kaum Anreize für einen Wechsel. In Verbindung mit der Bedeutung privater, quelloffener KI-Videomodelle ist klar, dass die Zukunft von Video zu einer weiteren technologischen Blackbox zu werden droht.

Hier haben Open-Source-Modelle in Verbindung mit dezentralen Netzen eine echte Chance, den KI-Engpass zu überwinden. Dezentrale Netzwerke sind ein Netzwerk von miteinander verbundenen GPUs, die KI-Aufgaben verarbeiten können. Die Verwendung eines offenen Stellenmarktmodells in einem dezentralen Netzwerk wie Livepeer bedeutet, dass Entwickler und kleine Unternehmen einfach einzelne Inferenzaufgaben zu minimalen Kosten bearbeiten können, anstatt ganze Server zu mieten. Dadurch wird der größte Kostenfaktor bei der KI-Videoberechnung im Wesentlichen vermieden.

Ein offener und dezentral arbeitender KI-Marktplatz wie Livepeer ist die kosteneffizienteste und zugänglichste Option, um das volle Potenzial von KI-Video auszuschöpfen. Mit erschwinglicher Datenverarbeitung steht die Möglichkeit, mit Modellen zu experimentieren und innovative Anwendungen zu entwickeln, allen kreativen Entwicklern und Unternehmen offen, unabhängig von ihrer Finanzierung.

KI-Video ist noch eine sehr junge Technologie. Der Zugang zu neuen und aufregenden Technologien ist oft beschränkt und teuer, nimmt aber mit dem Aufkommen der Konkurrenz ab. Damit dies bei KI-Video der Fall ist, müssen sich die Grundlagen der Technologie ändern, oder die Konkurrenz wird einfach aus dem Markt gedrängt.

Livepeer ist ein Video-Infrastrukturnetzwerk für Live- und On-Demand-Streaming. Es hat KI-Videocomputing-Fähigkeiten (KI-Subnet) integriert, die sein massives GPU-Netzwerk nutzen, und plant, ein wichtiger Infrastrukturakteur im Bereich des videofokussierten KI-Computings zu werden.