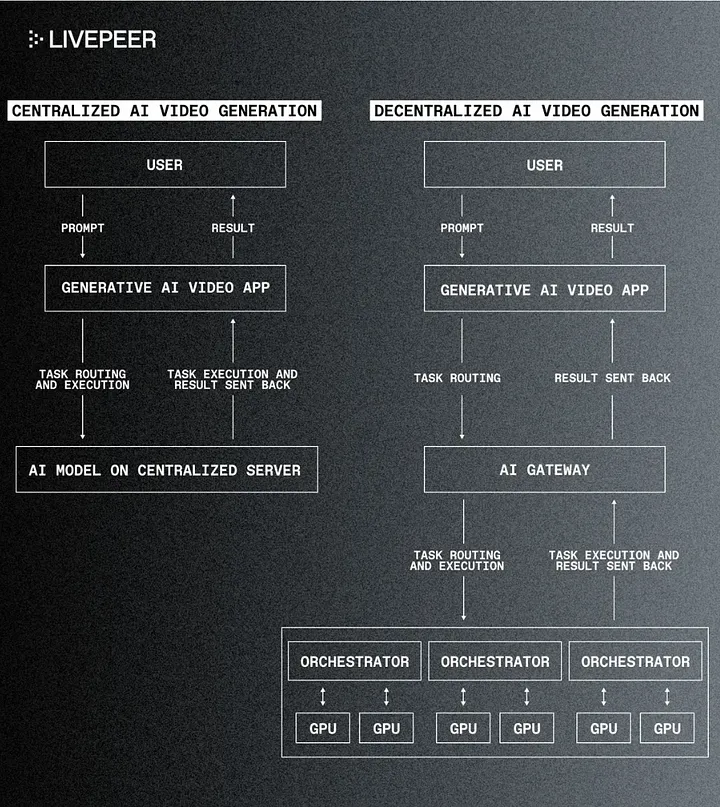

Die rasante Entwicklung der generativen KI hat eine neue Ära der Kreativität und Innovation eingeläutet. Leistungsstarke Tools wie Sora und Stable Diffusion von OpenAI haben die Magie der Text-zu-Video-Generierung demonstriert und innerhalb weniger Monate nach der öffentlichen Vorstellung ihrer neuesten KI-Produkte Millionen von Nutzern angezogen. Dennoch gibt es immer noch eine große Hürde, damit KI ihr volles Potenzial entfalten kann: die kostspielige Zentralisierung von KI-Rechenressourcen, die zu erheblichen Engpässen geführt hat, die die Preise für Entwickler und Kreative gleichermaßen in die Höhe treiben.

Dezentralisierte KI-Dienste bieten eine überzeugende Alternative. Durch die Verteilung von Rechenressourcen auf ein Netzwerk einzelner Mitwirkender kann ein dezentraler Ansatz die Kosten drastisch senken, die Zugänglichkeit erhöhen und ein offeneres und innovatives Ökosystem fördern. Hier untersuchen wir, wie Entwickler einen vollständig dezentralisierten generativen KI-Tech-Stack erstellen können und welche Vorteile dies mit sich bringt.

Der dezentralisierte Gen AI Tech Stack

-

Infrastruktur und Rechenressourcen

-

Livepeer AI

-

Akash Network

-

-

Foundation Modelle

-

EleutherAI’s GPT-J

-

BLOOM (BigScience)

-

-

Entwicklungs-Frameworks

-

PySyft

-

FATE

-

-

Feinabstimmung und Anpassungstools

-

Hugging Face’s Adapters

-

PET (Pattern-Exploiting Training

-

-

Datenverarbeitung und -verwaltung

-

Livepeer AI

-

Filecoin

-

Infrastruktur und Berechnungsressourcen

Generative KI ist abhängig von der Recheninfrastruktur, auf der sie läuft. In einem dezentralen Ökosystem ist diese Infrastruktur auf zahlreiche Knotenpunkte verteilt, was Vorteile in Bezug auf Skalierbarkeit, Kosteneffizienz und Ausfallsicherheit bietet.

Livepeer AI

Livepeer AI ist ein dezentrales Netzwerk, das für die KI-Videoverarbeitung optimiert ist. Es nutzt seine weit verbreiteten, etablierten Hardware-Anbieter, die bereits jede Woche Millionen von Minuten herkömmlicher Videos mit viel verfügbarer GPU-Kapazität transkodieren, um auch kostengünstige generative KI-Aufgaben zu unterstützen.

Vorteile:

-

KI-Videofokus optimiert Text-zu-Bild-, Bild-zu-Bild- und Bild-zu-Video-Konvertierungen

-

Kostengünstigeres Pay-per-Task-Modell als die Reservierung teurer zentraler Kapazitäten

-

Eliminiert das Single-Point-of-Failure-Risiko, das mit stark zentralisierten Cloud-Servern einhergeht

Akash- Network

Akash ist ein dezentraler Cloud-Computing-Marktplatz, der sich auf den Einsatz von Containern konzentriert und über einzigartige Fähigkeiten beim Hosten von maschinellen Lernmodellen für Inferenzen und beim Betrieb von Validatoren und Knoten für verschiedene Blockchains verfügt, und das oft zu deutlich niedrigeren Preisen als zentrale Anbieter.

Vorteile:

-

Container-native Struktur ist für die Bereitstellung von containerisierten Anwendungen optimiert

-

Hohe Leistung durch Nutzung ungenutzter Rechenzentrumskapazitäten

-

Interoperabilität ermöglicht die Unterstützung verschiedener Container-Orchestrierungstools

Zusammenfassung:

-

Livepeer AI ist eine maßgeschneiderte Wahl, wenn Ihr Hauptaugenmerk auf Videoverarbeitung, Streaming oder medienbezogenen Anwendungen liegt, da es speziell für Videotranscoding, KI-gesteuerte Videoverbesserungen und Streaming-Skalierbarkeit optimiert ist.

-

Akash Network eignet sich möglicherweise besser für breitere Rechenanwendungen, einschließlich der Bereitstellung von KI/ML-Modellen, dezentralen Anwendungen oder Blockchain-Knoten.

Foundation-Modelle

Foundation-Modelle die auch als große KI-Modelle bezeichnet werden, sind fortgeschrittene KI-Systeme, die auf großen Datenmengen trainiert werden, um eine Vielzahl von Aufgaben zu erfüllen, z. B. die Generierung von Ausgaben aus Aufforderungen. Sie bilden das Fundament, auf dem generative KI-Anwendungen aufgebaut werden. Während zentralisierte Modelle wie GPT-3 oder DALL-E viel Aufmerksamkeit auf sich gezogen haben, bieten ihre dezentralisierten Gegenstücke einzigartige Vorteile.

EleutherAI

Die von EleutherAI entwickelten Open-Source-Sprachmodelle, darunter GPT-J und das neuere GPT-NeoX, sind so konzipiert, dass sie mit den Fähigkeiten von OpenAIs GPT-3 konkurrieren können - so sehr, dass Jack Clark, der Autor des Newsletters Import AI, sie als „Angriff auf die politische Ökonomie der KI“ bezeichnet hat.

Vorteile:

-

Der Open-Source-Charakter sorgt für Transparenz und von der Gemeinschaft betriebene Verbesserungen

-

Kann lokal ausgeführt werden und verringert die Abhängigkeit von Cloud-Diensten

-

Keine Nutzungsbeschränkungen oder API-Kosten wie bei proprietären Modellen

BLOOM (BigScience)

BLOOM ist ein mehrsprachiges, umfangreiches Sprachmodell, das im Rahmen einer Open-Source-Gemeinschaftsarbeit von mehr als 1000 Forschern weltweit entwickelt wurde.

Vorteile:

-

Unterstützt mehr als 46 Sprachen und kann für bestimmte Bereiche oder Sprachen fein abgestimmt werden

-

Ermöglicht Forschung und Innovation ohne kommerzielle Zwänge

-

Community-gesteuerte Entwicklung gewährleistet vielfältige Perspektiven

Zusammenfassung:

EleutherAI könnte Ihre Wahl sein, wenn Sie Wert auf größere Open-Source-Flexibilität, Stabilität und eine basisorientierte Forschergemeinschaft legen.

BLOOM ist die bessere Wahl, wenn Ihnen mehrsprachige Unterstützung, ein global vielfältiger Entwicklungsansatz und ein bewusster Fokus auf ethische KI wichtig sind.

Rahmenbedingungen für die Entwicklung

Entwicklungsframeworks spielen eine entscheidende Rolle bei der Erstellung und dem Einsatz von KI-Modellen. Sie unterstützen die verteilte Datenverarbeitung, gewährleisten den Datenschutz und erleichtern die kollaborative Entwicklung. Sie spielen während des gesamten Entwicklungsprozesses eine Rolle, von der Datenaufbereitung und dem Training bis hin zu Tests und Einsatz.

PySyft

PySyft ist eine Open-Source-Bibliothek für sicheres und privates Deep Learning, entwickelt von OpenMined. Sie bewahrt die Privatsphäre, indem sie Berechnungen auf verschlüsselten Daten ermöglicht, ohne diese vorher zu entschlüsseln.

Vorteile:

-

Berechnungen mit mehreren Beteiligten ermöglichen kollaborative KI-Entwicklung ohne gemeinsame Nutzung von Rohdaten

-

Interoperabel mit gängigen Deep-Learning-Frameworks wie PyTorch und TensorFlow

-

Erweiterbar, unterstützt benutzerdefinierte Operationen und Protokolle zur Wahrung der Privatsphäre

Federated AI Technology Enabler (FATE)

FATE ist ein Open-Source-Projekt, das von der KI-Abteilung von Webank initiiert wurde, um ein sicheres Computing-Framework für föderierte KI mit einem modularen Design für eine flexible Bereitstellung und Anpassung bereitzustellen.

Vorteile:

-

Umfassende Unterstützung für verschiedene föderierte Lernalgorithmen und Architekturen

-

Skalierbares Design, optimiert für groß angelegte industrielle Anwendungen

-

Funktioniert plattformübergreifend mit Unterstützung für heterogene Computerumgebungen

Zusammenfassung:

-

Das dezentralisierte Modell von PySyft kann viele datenschutzfreundliche Anwendungsfälle unterstützen, z. B. die gemeinsame Forschung im Gesundheitswesen an sensiblen Patientendaten oder die Betrugserkennung in mehreren Banken, ohne dass Kundendaten ausgetauscht werden.

-

Die organisationsübergreifenden Funktionen von FATE können die gemeinsame Modellschulung über verschiedene Unternehmen oder Institutionen hinweg unterstützen und föderiertes Lernen für verteilte Sensornetzwerke in Bereichen wie IoT oder Edge Computing ermöglichen.

Feinabstimmung und Anpassung Tools

Während Basismodelle leistungsstarke Allzweckfähigkeiten bieten, ermöglichen Feinabstimmungs- und Anpassungstools den Entwicklern, diese Modelle für bestimmte Aufgaben oder Bereiche anzupassen. In einem dezentralisierten KI-Ökosystem spielen diese Tools eine entscheidende Rolle bei der Demokratisierung der KI-Entwicklung und ermöglichen eine Anpassung, ohne dass umfangreiche Rechenressourcen erforderlich sind.

Adapter von Hugging Face

Hugging Face Adapters sind leichtgewichtige, trainierbare Module, die zu bereits trainierten Modellen hinzugefügt werden können, um sie an bestimmte Aufgaben anzupassen, ohne dass das gesamte Modell feinabgestimmt werden muss, wobei deutlich weniger Rechenressourcen verbraucht werden.

Vorteile:

-

Mehrere Adapter können für unterschiedliche Aufgaben trainiert und bei Bedarf ausgetauscht werden

-

Kann auf sensible Daten trainiert werden, ohne dass das gesamte Modell offengelegt wird

-

Einfachere Verwaltung und Versionskontrolle im Vergleich zu vollständigen Modellprüfpunkten

PET (Pattern-Exploiting Training)

PET ist eine „few-shot“-Lerntechnik, die sich aufgabenspezifische Muster zunutze macht, um die Modellleistung bei begrenzten beschrifteten Daten zu verbessern (ein Szenario, in dem nur wenige Daten für das Training von Machine-Learning-Modellen zur Verfügung stehen).

Vorteile:

-

Dateneffizient, gute Leistung mit sehr wenigen Datenbeispielen

-

Ermöglicht KI-Anwendungen in Bereichen, in denen große beschriftete Datensätze knapp oder teuer zu beschaffen sind

-

Erleichtert verteilte Lernszenarien, bei denen die Daten nicht zentralisiert werden können

Zusammenfassung:

-

Hugging-Face-Adapter sind ideal, wenn Sie eine parameter-effiziente Feinabstimmung und Modularität benötigen und von dem von Hugging Face bereitgestellten Ökosystem profitieren möchten.

-

Pattern-Exploiting Training (PET) kann vorzuziehen sein, wenn Sie label-effizientes Lernen benötigen, in einer Umgebung mit geringem Datenaufkommen arbeiten und einen prompt-basierten Lernansatz für Aufgaben wie Klassifizierung oder Lernen mit wenigen Treffern bevorzugen.

Datenverarbeitung und Management

Eine effiziente und sichere Datenverwaltung ist für die KI-Entwicklung entscheidend, insbesondere in einem dezentralen Ökosystem. Diese Komponente des Stacks konzentriert sich auf die Art und Weise, wie Daten gespeichert, geteilt und auf verteilte Weise verarbeitet werden.

Filecoin

Filecoin ist ein dezentralisiertes Speichernetzwerk, das Cloud-Speicher in einen algorithmischen Markt verwandelt. Es ermöglicht die verteilte Langzeitspeicherung großer KI-Datensätze und die Archivierung von KI-Forschungsdaten, neben anderen Anwendungsfällen.

Vorteile:

-

Verteilte Speicherung nutzt ungenutzte Speicherkapazitäten auf der ganzen Welt

-

Ausfallsicherere Daten, verteilt auf mehrere Knotenpunkte für Redundanz

-

Überprüfbar durch kryptografische Beweise, die zeigen, dass die Daten korrekt gespeichert werden

Livepeer AI

Livepeer AI ist zwar in erster Linie ein Infrastrukturanbieter, spielt aber auch eine entscheidende Rolle bei der Datenverarbeitung, insbesondere bei generativen KI-Aufgaben im Zusammenhang mit Videos. Darüber hinaus ist Livepeer AI das erste offene Infrastrukturnetzwerk, das der Coalition for Content Provenance and Authenticity (CP2a) beigetreten ist. CP2a ist ein offener technischer Standard, der Verlegern, Urhebern und Verbrauchern die Möglichkeit bietet, die Herkunft verschiedener Medientypen zurückzuverfolgen.

Vorteile:

-

Unterstützt Videoverarbeitungsaufgaben: Upscaling, Frame-Interpolation und Untertitelerstellung

-

Größere Ausfallsicherheit und Zensurresistenz verringern das Risiko von Datenverlust oder Nichtverfügbarkeit

-

Überprüfung der Herkunft und Authentizität von KI-Videoinhalten

Zusammenfassung:

-

Filecoin eignet sich am besten, wenn Ihr Schwerpunkt auf allgemeiner dezentraler Datenspeicherung liegt, insbesondere für große Daten, die langfristige Sicherheit und Redundanz benötigen.

-

Livepeer AI ist ideal, wenn Sie Videoinhalte in Echtzeit verarbeiten, verwalten oder verbessern müssen, insbesondere wenn KI/ML-Videoanalyse oder kosteneffizientes Streaming für Ihre Plattform wichtig ist.

Sie können Ihren dezentralen KI-Tech-Stack mit Livepeer AI testen, der von unserer Community optimiert wurde, um generative KI-Aufgaben für Entwickler und Kreative zu vereinfachen.

Dieser Artikel wurde von Andy Schreiber ins deutsche übersetzt, Moderator des deutschsprachigen Kanals von Live Pioneers der Community für Livepeer Enthusiasten.